Pandas – это мощная библиотека программирования на языке Python, предназначенная для обработки и анализа данных.

Она предоставляет высокоуровневые структуры данных, такие как DataFrame (таблицы данных) и Series (одномерные массивы), которые облегчают работу с табличными данными. Pandas включает в себя функциональность для чтения, записи, фильтрации, агрегации, визуализации и многих других операций с данными.

Важные особенности Pandas:

- DataFrame: Основная структура данных в Pandas, представляющая собой двумерную таблицу с метками строк и столбцов. Это удобный способ представления и манипулирования табличными данными.

- Series: Одномерный массив данных, который может быть использован в качестве столбца в DataFrame. Series обладает индексом, что делает его более гибким для работы с данными.

- Мощные инструменты для анализа данных: Pandas предоставляет функционал для фильтрации, сортировки, группировки, агрегации и многих других операций, что делает его отличным инструментом для аналитики и исследования данных.

- Поддержка временных данных: Pandas обладает удобными средствами работы с временными рядами, что делает его популярным инструментом в области финансов, анализа временных рядов и статистики.

- Интеграция с другими библиотеками: Pandas легко интегрируется с другими популярными библиотеками Python, такими как NumPy, Matplotlib и SciPy, что позволяет создавать комплексные аналитические решения.

Коротко говоря, Pandas предоставляет эффективные инструменты для обработки и анализа данных, что делает его неотъемлемой частью инструментария для специалистов по анализу данных и разработчиков в области машинного обучения.

Преимущества использования Pandas для анализа данных:

- Pandas предоставляет удобные и эффективные структуры данных (DataFrame и Series) для работы с табличными данными.

- Библиотека обладает мощными инструментами для обработки, фильтрации и анализа данных.

- Pandas легко интегрируется с другими библиотеками Python, такими как NumPy, Matplotlib и SciPy.

Установка и импорт библиотеки

Установка:

- Для установки Pandas используйте команду:

pip install pandas.

Импорт в Python:

- После установки, импортируйте библиотеку в свой скрипт или блокнот с помощью команды:

import pandas as pd.

Пример использования:

import pandas as pd

# Создание DataFrame (таблицы данных)

data = {'Имя': ['Анна', 'Борис', 'Светлана'],

'Возраст': [25, 30, 22],

'Зарплата': [50000, 70000, 45000]}

df = pd.DataFrame(data)

# Вывод первых строк таблицы

print(df.head())

Этот код создает простую таблицу данных с именами, возрастом и зарплатой, а затем выводит первые строки этой таблицы.

Основные термины и примеры использования

Series:

- Что это: Series — это одномерный массив (подобный списку) данных в библиотеке Pandas. Он может содержать данные любого типа, включая числа, строки и другие объекты.

- Пример:

import pandas as pd # Создание Series из списка my_series = pd.Series([10, 20, 30, 40, 50]) print(my_series)Вывод:

0 10 1 20 2 30 3 40 4 50 dtype: int64

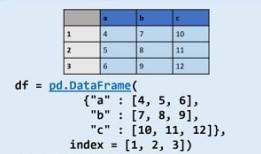

DataFrame:

- Что это: DataFrame — это двумерная таблица данных, представленная в виде структуры с метками строк и столбцов. Можно представить его как электронную таблицу или базу данных.

- Пример:

import pandas as pd # Создание DataFrame из словаря data = {'Имя': ['Анна', 'Борис', 'Светлана'], 'Возраст': [25, 30, 22], 'Зарплата': [50000, 70000, 45000]} my_dataframe = pd.DataFrame(data) print(my_dataframe)Вывод:

Имя Возраст Зарплата 0 Анна 25 50000 1 Борис 30 70000 2 Светлана 22 45000

Индекс:

- Что это: Индекс — это метка, присвоенная каждой строке в Series или DataFrame. Он обеспечивает уникальную идентификацию каждой записи и упрощает доступ и манипуляции с данными.

- Пример:

import pandas as pd # Создание DataFrame с явным заданием индекса data = {'Имя': ['Анна', 'Борис', 'Светлана'], 'Возраст': [25, 30, 22], 'Зарплата': [50000, 70000, 45000]} my_dataframe = pd.DataFrame(data, index=['сотрудник1', 'сотрудник2', 'сотрудник3']) print(my_dataframe)Вывод:

Имя Возраст Зарплата сотрудник1 Анна 25 50000 сотрудник2 Борис 30 70000 сотрудник3 Светлана 22 45000

Способы создания индексов

В Pandas индекс можно создать различными способами. Давайте рассмотрим несколько вариантов:

- Не задавать индекс в явном виде:

import pandas as pd data = {'Имя': ['Анна', 'Борис', 'Светлана'], 'Возраст': [25, 30, 22], 'Зарплата': [50000, 70000, 45000]} my_dataframe = pd.DataFrame(data) print(my_dataframe)Имя Возраст Зарплата 0 Анна 25 50000 1 Борис 30 70000 2 Светлана 22 45000В этом случае Pandas автоматически создаст целочисленный индекс, начиная с 0.

- Создание индекса на основе столбца данных:

import pandas as pd data = {'Имя': ['Анна', 'Борис', 'Светлана'], 'Возраст': [25, 30, 22], 'Зарплата': [50000, 70000, 45000]} my_dataframe = pd.DataFrame(data) # Используем столбец "Имя" в качестве индекса my_dataframe.set_index('Имя', inplace=True) print(my_dataframe)Возраст Зарплата Имя Анна 25 50000 Борис 30 70000 Светлана 22 45000В этом примере столбец «Имя» стал индексом DataFrame.

- Создание вычисляемого или генерируемого индекса:

import pandas as pd data = {'Возраст': [25, 30, 22], 'Зарплата': [50000, 70000, 45000]} my_dataframe = pd.DataFrame(data) # Генерация индекса от 100 my_dataframe.index = range(100, 100 + len(my_dataframe)) print(my_dataframe)Возраст Зарплата 100 25 50000 101 30 70000 102 22 45000В этом примере мы создали индекс, начиная с числа 100.

Работа с индексами

Работа с индексами в Pandas предоставляет множество возможностей для управления данными и выполнения операций, таких как сортировка, смена и перестройка индексов. Вот основные способы работы с индексами и их методы:

- Сортировка индекса: Методы для сортировки индекса позволяют упорядочить строки в датафрейме или серии на основе значений индекса.

sort_index(): Сортирует индекс по возрастанию или убыванию.

Пример:

df.sort_index(ascending=False) # Сортировка индекса по убыванию - Смена индекса: Методы для изменения индекса позволяют заменить текущий индекс на другой столбец или на другую последовательность значений.

set_index(): Устанавливает новый индекс, используя значения из одного или нескольких столбцов.

Пример:

df.set_index('new_index_column') # Установка нового индекса на основе столбца 'new_index_column' - Перестройка индекса: Методы для перестройки индекса позволяют изменить порядок или значения индекса без изменения данных.

reindex(): Перестраивает индекс на основе новых меток индекса или дополняет его новыми метками.

Пример:

df.reindex(new_index_labels) # Перестройка индекса на основе новых меток индекса

Кроме того, у этих методов есть дополнительные параметры:

axis: Определяет, сортируется или перестраивается индекс по строкам (axis=0, по умолчанию) или по столбцам (axis=1).ascending: Определяет порядок сортировки индекса (Trueдля возрастания,Falseдля убывания).level: При работе с иерархическими индексами позволяет указать уровень, по которому производится сортировка или перестройка.fill_value: При перестройке индекса определяет значение, которое будет использоваться для заполнения отсутствующих меток.

Пример работы с индексами на прикладных данных:

import pandas as pd

# Создание датафрейма с индексом из дат

dates = pd.date_range('2022-01-01', periods=5)

df = pd.DataFrame({'A': [1, 2, 3, 4, 5]}, index=dates)

# Смена индекса на другой столбец

df.set_index('A')

# Перестройка индекса на основе новых меток

new_index = pd.date_range('2022-01-02', periods=6)

df.reindex(new_index)

# Сортировка индекса по убыванию

df.sort_index(ascending=False)

Практическое применение Series

Series в Pandas — это одномерный массив с метками, который может содержать данные различных типов. Он может быть использован для представления одного столбца данных в DataFrame или просто для работы с одномерными данными. Несколько практических примеров применения Series:

- Извлечение столбца из DataFrame: Метод

DataFrame['column_name']возвращаетSeries, который представляет один столбец данных из DataFrame.import pandas as pd # Создание DataFrame для примера data = {'A': [1, 2, 3], 'B': [4, 5, 6]} df = pd.DataFrame(data) # Извлечение столбца 'A' в виде Series series_A = df['A'] - Агрегирование данных:

Seriesможно использовать для вычисления статистических показателей, таких как среднее значение, медиана, минимум, максимум и т. д.# Вычисление среднего значения для столбца 'A' mean_A = series_A.mean() - Фильтрация данных:

Seriesможет быть использован для фильтрации данных по определенному условию.# Фильтрация значений больше 2 filtered_series = series_A[series_A > 2] - Итерация по данным:

Seriesможно использовать для итерации по элементам и выполнения каких-либо операций.# Итерация по элементам Series for value in series_A: print(value) - Индексирование и выборка данных:

Seriesподдерживает различные методы индексации и выборки данных.# Выборка данных по индексу value_at_index_0 = series_A[0] - Визуализация данных:

Seriesможет быть использован для создания графиков и визуализации данных.# Построение графика series_A.plot() - Выполнение операций с другими Series:

Seriesможно использовать для выполнения операций с другими Series, включая арифметические операции.# Выполнение арифметической операции с другим Series series_sum = series_A + df['B']

Цепочки методов

Цепочки методов в библиотеке Pandas позволяют комбинировать несколько операций обработки данных в одну последовательность, что делает код более компактным и удобным. Вот несколько примеров применения цепочек методов:

Пример 1: Фильтрация, группировка и агрегация данных

import pandas as pd

# Создание датафрейма с реальными данными

data = {

'Город': ['Москва', 'Санкт-Петербург', 'Москва', 'Санкт-Петербург', 'Москва'],

'Температура': [25, 23, 28, 22, 27],

'Влажность': [50, 60, 45, 55, 48]

}

df = pd.DataFrame(data)

# Фильтрация данных для города Москва и вычисление средней температуры

average_temp_moscow = df[df['Город'] == 'Москва'].groupby('Город')['Температура'].mean()

print(average_temp_moscow)

Пример 2: Преобразование данных и сортировка

import pandas as pd

# Создание датафрейма с реальными данными

data = {

'Имя': ['Алексей', 'Мария', 'Иван', 'Екатерина', 'Дмитрий'],

'Зарплата': ['$5000', '$6000', '$4500', '$5500', '$4800']

}

df = pd.DataFrame(data)

# Удаление символа '$' и преобразование к числовому типу

df['Зарплата'] = df['Зарплата'].str.replace('$', '').astype(int)

# Сортировка по убыванию зарплаты

sorted_df = df.sort_values(by='Зарплата', ascending=False)

print(sorted_df)

Пример 3: Вычисление нового столбца и фильтрация

import pandas as pd

# Создание датафрейма с реальными данными

data = {

'Название': ['Продукт A', 'Продукт B', 'Продукт C', 'Продукт D'],

'Продажи_2022': [10000, 12000, 8000, 15000],

'Продажи_2023': [11000, 11500, 8500, 16000]

}

df = pd.DataFrame(data)

# Вычисление изменения продаж и фильтрация для увеличения продаж в 2023 году

filtered_df = df[(df['Продажи_2023'] - df['Продажи_2022']) > 0]

print(filtered_df)

Загрузка данных в датафреймы

Pandas предоставляет удобные функции для чтения данных из различных источников.

- Чтение из CSV-файла:

import pandas as pd # Чтение данных из CSV-файла my_dataframe = pd.read_csv('путь_к_файлу.csv') - Чтение из Excel-файла:

import pandas as pd # Чтение данных из Excel-файла my_dataframe = pd.read_excel('файл.xlsx', sheet_name='Лист1') - Чтение из SQL-запроса или базы данных:

import pandas as pd from sqlalchemy import create_engine # Создание соединения с базой данных engine = create_engine('sqlite:///:memory:') # В примере - временная база данных SQLite # Чтение данных из SQL-запроса query = "SELECT * FROM my_table;" my_dataframe = pd.read_sql(query, engine) - Чтение данных из веб-ресурса (например, CSV с веб-сервера):

import pandas as pd # Чтение данных из веб-ресурса url = 'https://example.com/data.csv' my_dataframe = pd.read_csv(url) - Чтение данных из JSON-файла:

import pandas as pd # Чтение данных из JSON-файла my_dataframe = pd.read_json('файл.json') - Чтение данных из Clipboard (буфера обмена):

import pandas as pd # Чтение данных из буфера обмена (Ctrl+C/Ctrl+V) my_dataframe = pd.read_clipboard() - Чтение данных из HTML-таблицы на веб-странице:

import pandas as pd # Чтение данных из HTML-таблицы на веб-странице url = 'https://example.com/page_with_table.html' tables = pd.read_html(url) my_dataframe = tables[0] # Выбор первой таблицы на странице

Параметры загрузки данных на примере метода read_csv

Функция read_csv в Pandas позволяет читать данные из CSV-файла. Вот некоторые основные параметры, которые можно использовать при вызове этой функции:

filepath_or_buffer(обязательный):import pandas as pd # Чтение данных из CSV-файла my_dataframe = pd.read_csv('путь_к_файлу.csv')- Определяет путь к файлу или URL.

Пример:

sep(по умолчанию,):my_dataframe = pd.read_csv('файл.csv', sep='\t')- Определяет разделитель между данными.

Пример с табуляцией в качестве разделителя:

header(по умолчаниюinfer):- Указывает номер строки, которая содержит заголовки, или использует

infer, чтобы автоматически определить.

Пример с явным указанием строки заголовков:

my_dataframe = pd.read_csv('файл.csv', header=0)- Указывает номер строки, которая содержит заголовки, или использует

names:- Позволяет задать собственные имена для столбцов.

Пример:

my_dataframe = pd.read_csv('файл.csv', names=['Имя', 'Возраст', 'Зарплата'])index_col(по умолчаниюNone):- Указывает номер столбца, который следует использовать в качестве индекса, или

None, если индекс не требуется.

Пример:

- Указывает номер столбца, который следует использовать в качестве индекса, или

skiprows:- Пропускает указанные строки при чтении файла.

Пример:

my_dataframe = pd.read_csv('файл.csv', skiprows=[0, 2, 3])usecols:- Определяет, какие столбцы использовать при чтении данных.

Пример:

my_dataframe = pd.read_csv('файл.csv', usecols=['Имя', 'Возраст'])dtype:- Задает тип данных для столбцов.

Пример:

my_dataframe = pd.read_csv('файл.csv', dtype={'Возраст': 'float64'})

Это только часть параметров. В функции read_csv существует еще множество других параметров, которые позволяют настроить процесс чтения данных в соответствии с конкретными требованиями. При необходимости можно обращаться к официальной документации Pandas для получения подробной информации о всех параметрах функции.

Работа с Excel источниками в Pandas

Класс ExcelFile в библиотеке Pandas предоставляет возможность работы с файлами формата Excel (.xls и .xlsx) без необходимости загрузки всего файла в память. Вместо этого он представляет объект, который может быть использован для чтения данных из листов Excel.

Основные возможности класса ExcelFile:

- Чтение данных из Excel файлов:

ExcelFileпозволяет открыть Excel файл и прочитать данные из него. При этом можно указать определенный лист, который требуется прочитать. - Информация о содержимом: Методы

sheet_namesвозвращает список имен всех листов в файле Excel. Это позволяет предварительно ознакомиться с содержимым файла. - Параллельное чтение данных: При работе с большими файлами, использование

ExcelFileможет быть эффективнее, чем загрузка всего файла в память с помощьюpd.read_excel(), так как он позволяет параллельно читать данные из разных листов.

Пример использования ExcelFile:

import pandas as pd

# Создание объекта ExcelFile

excel_file = pd.ExcelFile('file.xlsx')

# Получение списка имен листов

sheet_names = excel_file.sheet_names

print(sheet_names)

# Чтение данных из конкретного листа

df = excel_file.parse('Sheet1')

# Обработка данных

print(df.head())

В этом примере, 'file.xlsx' — это путь к Excel файлу. Мы создаем объект ExcelFile и используем метод sheet_names для получения списка имен листов. Затем мы читаем данные из листа ‘Sheet1’ с помощью метода parse().

Запись в файл Excel

Класс ExcelWriter в библиотеке Pandas предоставляет возможность записи данных в файлы формата Excel (.xls и .xlsx). Этот класс позволяет создавать новые файлы Excel или дополнять существующие, а также позволяет работать с несколькими листами внутри одного файла.

Основные возможности класса ExcelWriter:

- Создание новых файлов Excel:

ExcelWriterпозволяет создавать новые файлы Excel для записи данных. - Запись данных в файлы Excel: После создания объекта

ExcelWriterможно записывать данные из DataFrame в файл Excel. Это можно делать с помощью методаto_excel()DataFrame. - Работа с несколькими листами:

ExcelWriterпозволяет создавать или записывать данные в несколько листов внутри одного файла Excel. Это может быть полезно при организации данных по различным категориям или при сохранении нескольких DataFrame в один файл. - Управление форматированием:

ExcelWriterпозволяет настраивать различные аспекты форматирования Excel файлов, такие как ширина столбцов, высота строк, формат ячеек и т. д.

Пример использования ExcelWriter:

import pandas as pd

# Создание объекта ExcelWriter и указание пути к файлу

excel_writer = pd.ExcelWriter('output.xlsx')

# Создание DataFrame для записи в Excel

data = {'Name': ['Alice', 'Bob', 'Charlie'],

'Age': [25, 30, 35]}

df = pd.DataFrame(data)

# Запись DataFrame в лист 'Sheet1' файла Excel

df.to_excel(excel_writer, sheet_name='Sheet1', index=False)

# Создание нового листа и запись в него

df2 = pd.DataFrame({'A': [1, 2, 3], 'B': [4, 5, 6]})

df2.to_excel(excel_writer, sheet_name='Sheet2', index=False)

# Сохранение изменений в файл Excel

excel_writer.save()

В этом примере мы создаем объект ExcelWriter с указанием имени файла. Затем мы записываем DataFrame в лист ‘Sheet1’ с помощью метода to_excel(), указывая объект ExcelWriter и имя листа. После этого мы создаем новый лист ‘Sheet2’ и записываем в него другой DataFrame. Наконец, мы сохраняем изменения в файл Excel с помощью метода save().

Основные операции с данными в Pandas

Навигация и просмотр данных

- Просмотр первых и последних строк:

- Используйте методы

head()иtail()для просмотра первых и последних строк соответственно. Это позволяет быстро оценить структуру данных.import pandas as pd # Создание DataFrame для примера data = {'Имя': ['Анна', 'Борис', 'Светлана'], 'Возраст': [25, 30, 22], 'Зарплата': [50000, 70000, 45000]} my_dataframe = pd.DataFrame(data) # Просмотр первых 2 строк print(my_dataframe.head(2)) # Просмотр последних 2 строк print(my_dataframe.tail(2))

- Используйте методы

Имя Возраст Зарплата

0 Анна 25 50000

1 Борис 30 70000

Имя Возраст Зарплата

1 Борис 30 70000

2 Светлана 22 45000- Получение отдельных значений в таблице

- Методы

atиiatв библиотеке Pandas используются для доступа к отдельным значениям в датафрейме по их метке (дляat) или целочисленной позиции (дляiat).Методat:- Параметры:

row_label: метка строки.col_label: метка столбца.

- Пример использования:

import pandas as pd # Создание датафрейма с реальными данными data = { 'A': [1, 2, 3, 4, 5], 'B': [6, 7, 8, 9, 10], 'C': [11, 12, 13, 14, 15] } df = pd.DataFrame(data, index=['a', 'b', 'c', 'd', 'e']) # Получение значения в строке 'b', столбце 'B' с помощью метода at value_at = df.at['b', 'B'] print("Значение в строке 'b', столбце 'B':", value_at)

- Параметры:

- Метод

iat:- Параметры:

row_index: индекс строки (целочисленная позиция).col_index: индекс столбца (целочисленная позиция).

- Пример использования:

import pandas as pd # Создание датафрейма с реальными данными data = { 'A': [1, 2, 3, 4, 5], 'B': [6, 7, 8, 9, 10], 'C': [11, 12, 13, 14, 15] } df = pd.DataFrame(data) # Получение значения в первой строке, втором столбце с помощью метода iat value_iat = df.iat[0, 1] print("Значение в первой строке, втором столбце:", value_iat)

- Параметры:

- Методы

- Получение отдельных строк, столбцов, фрагментов:

- Используйте различные методы для индексации и выборки данных, такие как

loc(для работы с метками) иiloc(для работы с числовыми индексами).# Выбор строки по метке row = my_dataframe.loc[1] # Выбор строки по числовому индексу row = my_dataframe.iloc[1] # Выбор столбца по метке column = my_dataframe['Имя'] # Выбор определенных ячеек value = my_dataframe.at[1, 'Имя'] locв Pandas используется для доступа к группе строк и столбцов по их меткам. Метки могут быть значениями в индексе (строках) или именами столбцов.- Если при создании DataFrame не был явно указан индекс, Pandas создаст целочисленный индекс, начиная с 0. В этом случае метки строк будут значениями целочисленного индекса.

import pandas as pd data = {'Имя': ['Анна', 'Борис', 'Светлана'], 'Возраст': [25, 30, 22], 'Зарплата': [50000, 70000, 45000]} my_dataframe = pd.DataFrame(data) # Использование целочисленных меток индекса first_row = my_dataframe.loc[0] - Метки могут быть явно указаны при создании DataFrame с помощью параметра

index.import pandas as pd data = {'Имя': ['Анна', 'Борис', 'Светлана'], 'Возраст': [25, 30, 22], 'Зарплата': [50000, 70000, 45000]} # Явное указание индекса my_dataframe = pd.DataFrame(data, index=['сотрудник1', 'сотрудник2', 'сотрудник3']) # Использование строковых меток индекса employee2 = my_dataframe.loc['сотрудник2'] - Метки могут также быть использованы для выбора конкретных столбцов.

# Использование меток столбцов age_salary = my_dataframe.loc[:, ['Возраст', 'Зарплата']] - Таким образом, метки берутся из индекса строк или имен столбцов, в зависимости от того, по какому измерению (строки или столбцы) вы осуществляете индексацию. Важно отметить, что при использовании

loc, последний элемент в диапазоне включается в результат, в отличие от среза в Python, где последний элемент исключается. - Взятие диапазона строк и столбцов:

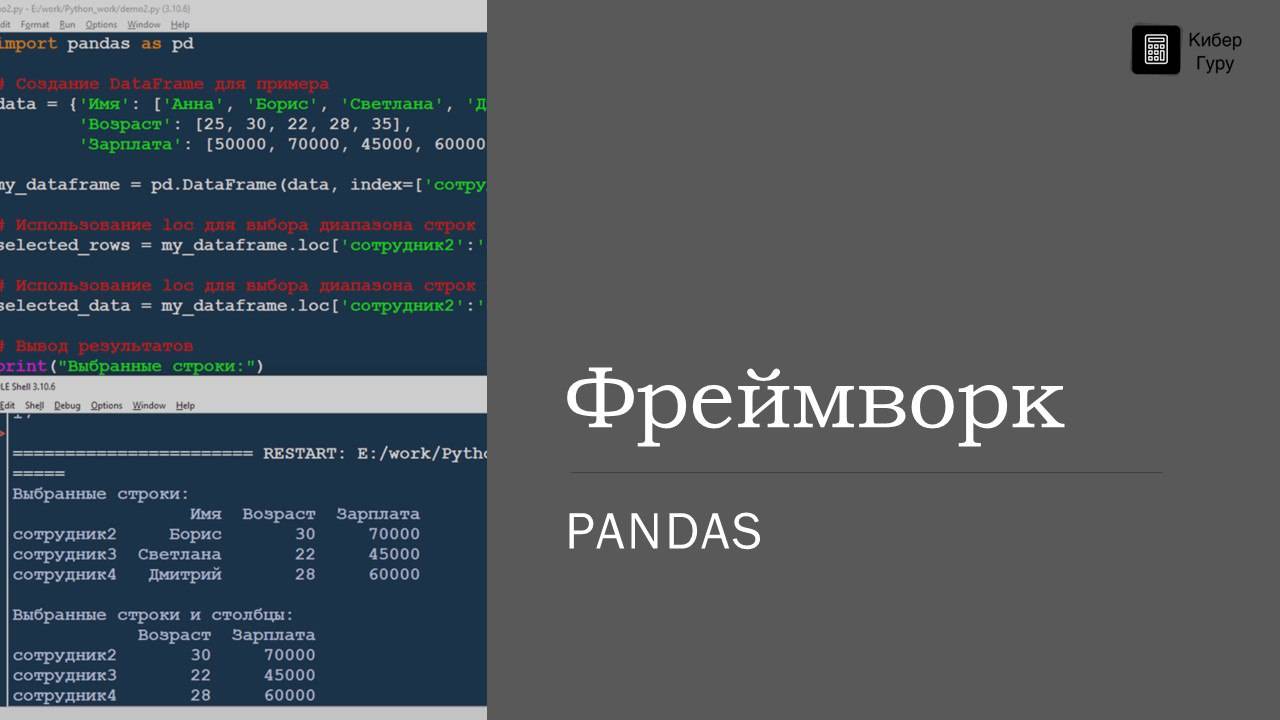

import pandas as pd # Создание DataFrame для примера data = {'Имя': ['Анна', 'Борис', 'Светлана', 'Дмитрий', 'Екатерина'], 'Возраст': [25, 30, 22, 28, 35], 'Зарплата': [50000, 70000, 45000, 60000, 80000]} my_dataframe = pd.DataFrame(data, index=['сотрудник1', 'сотрудник2', 'сотрудник3', 'сотрудник4', 'сотрудник5']) # Использование loc для выбора диапазона строк selected_rows = my_dataframe.loc['сотрудник2':'сотрудник4'] # Использование loc для выбора диапазона строк и столбцов selected_data = my_dataframe.loc['сотрудник2':'сотрудник4', 'Возраст':'Зарплата'] # Вывод результатов print("Выбранные строки:") print(selected_rows) print("\nВыбранные строки и столбцы:") print(selected_data)

- Используйте различные методы для индексации и выборки данных, такие как

Выбранные строки:

Имя Возраст Зарплата

сотрудник2 Борис 30 70000

сотрудник3 Светлана 22 45000

сотрудник4 Дмитрий 28 60000

Выбранные строки и столбцы:

Возраст Зарплата

сотрудник2 30 70000

сотрудник3 22 45000

сотрудник4 28 60000- Просмотр общей информации:

- Используйте методы

info()иdescribe(), а также атрибутаshapeдля получения общей информации о DataFrame.# Вывод общей информации о DataFrame my_dataframe.info() # Вывод статистики по числовым столбцам my_dataframe.describe()<class 'pandas.core.frame.DataFrame'> Index: 5 entries, сотрудник1 to сотрудник5 Data columns (total 3 columns): # Column Non-Null Count Dtype --- ------ -------------- ----- 0 Имя 5 non-null object 1 Возраст 5 non-null int64 2 Зарплата 5 non-null int64 dtypes: int64(2), object(1) memory usage: 332.0+ bytes

- Используйте методы

shape: Этот атрибут возвращает кортеж, содержащий количество строк и столбцов DataFrame.

Пример использования:

import pandas as pd

# Создание DataFrame

data = {'Имя': ['Алексей', 'Мария', 'Иван', 'Екатерина', 'Дмитрий']}

df = pd.DataFrame(data)

# Вывод количества строк и столбцов в DataFrame

print(df.shape)

Выбор строк и столбцов.

Выбор строк и столбцов в DataFrame в Pandas можно осуществлять различными способами, включая индексацию, фильтрацию данных и использование булевых условий. Давайте рассмотрим основные методы:

Выбор столбцов:

- По имени столбца:

# Выбор одного столбца по имени column_data = my_dataframe['Имя'] # Выбор нескольких столбцов по списку имен selected_columns = my_dataframe[['Имя', 'Возраст']] - По позиции столбца:

# Выбор одного столбца по позиции column_data = my_dataframe.iloc[:, 0] # Выбор нескольких столбцов по позициям selected_columns = my_dataframe.iloc[:, [0, 1]]

Выбор строк:

- По метке строки (индекс):

# Выбор одной строки по метке row_data = my_dataframe.loc['сотрудник1'] # Выбор нескольких строк по списку меток selected_rows = my_dataframe.loc[['сотрудник1', 'сотрудник3']] - По позиции строки (числовой индекс):

# Выбор одной строки по позиции row_data = my_dataframe.iloc[0] # Выбор нескольких строк по позициям selected_rows = my_dataframe.iloc[[0, 2]]

Получение случайной выборки

Метод sample в Pandas используется для получения случайной выборки из датафрейма. Вот основные параметры метода sample:

n: количество строк, которые вы хотите получить из датафрейма.frac: доля строк, которую вы хотите получить из датафрейма (от 0 до 1).replace: определяет, могут ли строки повторяться в выборке (по умолчанию False).weights: определяет вероятности для каждой строки, чтобы быть выбранной (по умолчанию None).random_state: устанавливает начальное значение для генератора случайных чисел (по умолчанию None).import pandas as pd # Создание датафрейма с реальными данными data = { 'Name': ['John', 'Alice', 'Bob', 'Emma', 'James'], 'Age': [25, 30, 35, 40, 45], 'City': ['New York', 'Los Angeles', 'Chicago', 'Houston', 'Philadelphia'] } df = pd.DataFrame(data) # Получение случайной выборки из датафрейма (3 случайные строки) sample1 = df.sample(n=3) print("Случайная выборка (3 строки):\n", sample1) # Получение случайной выборки из датафрейма (доля выборки) sample2 = df.sample(frac=0.5) print("\nСлучайная выборка (доля выборки):\n", sample2)

Этот код создает небольшой датафрейм с данными о людях и затем использует метод sample, чтобы получить случайную выборку из этого датафрейма. Вы можете использовать параметры метода sample, чтобы настроить размер и характеристики выборки в соответствии с вашими потребностями.

Фильтрация данных

- Фильтрация по условию:

# Фильтрация данных по условию filtered_data = my_dataframe[my_dataframe['Возраст'] > 25] - Использование метода

query():# Фильтрация данных с использованием метода query filtered_data = my_dataframe.query('Возраст > 25 and Зарплата > 50000')

Условия фильтрации:

Можно использовать следующие условия для фильтрации данных:

==(равно)!=(не равно)<(меньше)>(больше)<=(меньше или равно)>=(больше или равно)

Комбинирование условий:

Для комбинирования условий используйте логические операторы & (и), | (или) и ~ (не). Например:

# Комбинирование нескольких условий (И)

result_and = my_dataframe[(my_dataframe['Возраст'] > 25) & (my_dataframe['Зарплата'] > 50000)]

# Комбинирование нескольких условий (ИЛИ)

result_or = my_dataframe[(my_dataframe['Возраст'] > 30) | (my_dataframe['Зарплата'] > 60000)]

# Отрицание условия (НЕ)

result_not = my_dataframe[~(my_dataframe['Имя'] == 'Анна')]

Логические операторы и операторы сравнения. Полный список и описание.

В библиотеке Pandas доступны различные логические операторы и операторы сравнения для работы с данными в датафреймах. Давайте рассмотрим каждый из них:

- И (или логическое И): Обозначается символом

&. ВозвращаетTrue, если оба условия истинны. - ИЛИ (логическое ИЛИ): Обозначается символом

|. ВозвращаетTrue, если хотя бы одно из условий истинно. - НЕ (логическое НЕ): Обозначается символом

~. Используется для инвертирования значения условия. - ИСКЛЮЧАЮЩЕЕ ИЛИ: В Python представлено как

^. В Pandas его нет, но можно использовать логические операторы и инверсию для достижения подобного эффекта. - Равно: Обозначается

==. ВозвращаетTrue, если значения равны. - Не равно: Обозначается

!=. ВозвращаетTrue, если значения не равны. - Больше: Обозначается

>. ВозвращаетTrue, если первое значение больше второго. - Меньше: Обозначается

<. ВозвращаетTrue, если первое значение меньше второго. - Больше или равно: Обозначается

>=. ВозвращаетTrue, если первое значение больше или равно второму. - Меньше или равно: Обозначается

<=. ВозвращаетTrue, если первое значение меньше или равно второму. - Проверка на пустоту: Метод

isna()илиisnull()возвращаетTrue, если значение является пустым (NaN). - Проверка на не пустоту: Метод

notna()илиnotnull()возвращаетTrue, если значение не является пустым (NaN). - Проверка наличия значения в списке: Метод

isin()возвращаетTrue, если значение содержится в заданном списке. - all: Функция

all()возвращаетTrue, если все значения в объекте являютсяTrue. - any: Функция

any()возвращаетTrue, если хотя бы одно значение в объекте являетсяTrue.

Эти операторы и методы могут использоваться для создания условий фильтрации в методе query(), а также для фильтрации данных в обычном синтаксисе Pandas.

Пример использования на датафрейме бронирования авиаблиетов.

import pandas as pd

# Загрузка данных

bookings_df = pd.read_csv('bookings.csv')

# Проверка на пустоту (NaN)

print("Проверка на пустоту (NaN):")

print(bookings_df.isnull().head())

print()

# Проверка на не пустоту (не NaN)

print("Проверка на не пустоту (не NaN):")

print(bookings_df.notnull().head())

print()

# Проверка на наличие значений в списке

print("Проверка на наличие значений в списке:")

print(bookings_df['book_ref'].isin(['00000F', '000012', '000068']).head())

print()

# Проверка, что все значения в объекте истинны

print("Проверка, что все значения в объекте истинны:")

print(bookings_df['book_ref'].notnull().all())

print()

# Проверка, что хотя бы одно значение в объекте истинно

print("Проверка, что хотя бы одно значение в объекте истинно:")

print(bookings_df['book_ref'].notnull().any())

Текстовые фильтры

В Pandas можно создать фильтр «содержит» с помощью метода str.contains() для столбцов типа str и метода apply() с регулярным выражением для более общего случая.

1. Фильтр «содержит» с использованием метода str.contains():

# Создание фильтра для столбца 'column_name', где значения содержат подстроку 'substring'

filter_contains = df['column_name'].str.contains('substring')

Этот метод применяется к столбцам типа str и возвращает булеву серию, где True указывает на то, что значение содержит указанную подстроку, а False указывает на то, что значение не содержит эту подстроку.

2. Фильтр с помощью регулярных выражений с использованием метода apply():

import re

# Создание фильтра с использованием регулярного выражения

pattern = re.compile(r'regex_pattern')

filter_regex = df['column_name'].apply(lambda x: bool(pattern.search(str(x))))

В этом примере regex_pattern должен быть вашим регулярным выражением, которое будет применяться к значениям в столбце column_name. pattern.search(str(x)) ищет совпадения в каждом значении столбца с регулярным выражением.

Затем apply() применяет лямбда-функцию ко всем значениям в столбце, возвращая булеву серию, где True указывает на совпадение с регулярным выражением, а False — на отсутствие совпадения.

Примеры работы с фильтрами

Для примера использования различных методов фильтрации данных на практике возьмем датафрейм с данными о бронированиях авиабилетов из файла bookings.csv. Давайте загрузим данные и выполним несколько операций фильтрации:

import pandas as pd

# Загрузка данных

bookings_df = pd.read_csv('bookings.csv')

# Вывод первых нескольких строк датафрейма

print("До фильтрации:")

print(bookings_df.head())

# Фильтрация данных: выберем только бронирования с общей суммой больше 50 000

filtered_df_1 = bookings_df[bookings_df['total_amount'] > 50000]

# Фильтрация данных: выберем бронирования с датой более ранней, чем 2017-08-01

filtered_df_2 = bookings_df[pd.to_datetime(bookings_df['book_date']).dt.date < pd.to_datetime('2017-08-01').date()]

# Фильтрация данных: выберем бронирования с общей суммой больше 50 000 и совершенные после 2017-07-01

filtered_df_3 = bookings_df[(bookings_df['total_amount'] > 50000) & (pd.to_datetime(bookings_df['book_date']).dt.date > pd.to_datetime('2017-07-01').date())]

# Вывод результатов фильтрации

print("\nПосле фильтрации 1 (бронирования с общей суммой больше 50 000):")

print(filtered_df_1.head())

print("\nПосле фильтрации 2 (бронирования с датой более ранней, чем 2017-08-01):")

print(filtered_df_2.head())

print("\nПосле фильтрации 3 (бронирования с общей суммой больше 50 000 и совершенные после 2017-07-01):")

print(filtered_df_3.head())

Результаты работы фильтров

До фильтрации:

book_ref book_date total_amount

0 00000F 2017-07-05 05:12:00.000 +0500 265700.0

1 000012 2017-07-14 11:02:00.000 +0500 37900.0

2 000068 2017-08-15 16:27:00.000 +0500 18100.0

3 000181 2017-08-10 15:28:00.000 +0500 131800.0

4 0002D8 2017-08-07 23:40:00.000 +0500 23600.0

После фильтрации 1 (бронирования с общей суммой больше 50 000):

book_ref book_date total_amount

0 00000F 2017-07-05 05:12:00.000 +0500 265700.0

11 000374 2017-08-12 12:13:00.000 +0500 136200.0

20 00067B 2017-07-12 04:35:00.000 +0500 296700.0

После фильтрации 2 (бронирования с датой более ранней, чем 2017-08-01):

book_ref book_date total_amount

0 00000F 2017-07-05 05:12:00.000 +0500 265700.0

1 000012 2017-07-14 11:02:00.000 +0500 37900.0

5 0002DB 2017-07-29 08:30:00.000 +0500 101500.0

6 0002E0 2017-07-11 18:09:00.000 +0500 89600.0

7 0002F3 2017-07-10 07:31:00.000 +0500 69600.0

После фильтрации 3 (бронирования с общей суммой больше 50 000 и совершенные после 2017-07-01):

book_ref book_date total_amount

0 00000F 2017-07-05 05:12:00.000 +0500 265700.0

5 0002DB 2017-07-29 08:30:00.000 +0500 101500.0

6 0002E0 2017-07-11 18:09:00.000 +0500 89600.0

7 0002F3 2017-07-10 07:31:00.000 +0500 69600.0

10 000352 2017-07-06 04:02:00.000 +0500 109500.0

Фильтрация с помощью query()

Метод query() в библиотеке Pandas предназначен для фильтрации данных в датафрейме на основе условий, заданных в виде строкового выражения. Этот метод позволяет написать условия фильтрации в виде строки, что делает код более компактным и легким для чтения.

Основные параметры метода query():

expr: Строковое выражение, содержащее условия фильтрации.inplace: Логический параметр, определяющий, изменять ли оригинальный датафрейм или возвращать новый.

Пример использования метода query() с несколькими логическими операторами:

import pandas as pd

# Создание датафрейма

data = {'A': [1, 2, 3, 4, 5],

'B': [10, 20, 30, 40, 50]}

df = pd.DataFrame(data)

# Фильтрация данных с помощью метода query()

result = df.query('A > 2 & B < 40') # Фильтрация, где значение в столбце A больше 2 и значение в столбце B меньше 40

print(result)

Этот код отфильтрует датафрейм df таким образом, что будут выбраны строки, удовлетворяющие условиям «значение в столбце A больше 2» И «значение в столбце B меньше 40».

Если нужно использовать другие логические операторы, например, или или не, можно использовать соответствующие операторы в строковом выражении. Например:

result = df.query('A > 2 | B == 30') # Фильтрация, где значение в столбце A больше 2 или значение в столбце B равно 30

В этом случае будут выбраны строки, удовлетворяющие условиям «значение в столбце A больше 2» ИЛИ «значение в столбце B равно 30».

Работа с пропущенными значениями

Работа с пропущенными данными (NaN или None) в DataFrame важна при анализе данных, и Pandas предоставляет различные методы для обнаружения и обработки таких значений. Давайте рассмотрим основные аспекты работы с пропущенными данными:

Обнаружение пропущенных значений:

- Метод

isna()иisnull():- Методы возвращают DataFrame той же формы, что и исходный, но с булевыми значениями, где

Trueуказывает на пропущенные значения.# Обнаружение пропущенных значений missing_values = my_dataframe.isna()

- Методы возвращают DataFrame той же формы, что и исходный, но с булевыми значениями, где

- Метод

info():- Метод

info()выводит общую информацию о DataFrame, включая количество непропущенных значений и тип данных каждого столбца.# Вывод информации о DataFrame my_dataframe.info()

- Метод

- Метод

describe():

- Метод

describe()также может использоваться для вывода статистической информации, включая количество непропущенных значений.# Вывод статистики, включая количество непропущенных значений my_dataframe.describe()

- Метод

Обработка пропущенных значений:

- Удаление строк/столбцов с пропущенными значениями:

- Метод

dropna()позволяет удалить строки или столбцы с пропущенными значениями.# Удаление строк с пропущенными значениями my_dataframe_cleaned_rows = my_dataframe.dropna() # Удаление столбцов с пропущенными значениями my_dataframe_cleaned_columns = my_dataframe.dropna(axis=1)

- Метод

- Заполнение пропущенных значений:

- Метод

fillna()используется для заполнения пропущенных значений определенным значением или результатом операции.# Заполнение пропущенных значений средним значением по столбцу mean_age = my_dataframe['Возраст'].mean() my_dataframe_filled = my_dataframe.fillna({'Возраст': mean_age, 'Зарплата': 0})

- Метод

- Интерполяция значений:

- Метод

interpolate()позволяет интерполировать пропущенные значения на основе соседних значений.# Интерполяция пропущенных значений my_dataframe_interpolated = my_dataframe.interpolate()

- Метод

- Замена пропущенных значений другими значениями:

- Метод

replace()может использоваться для замены пропущенных значений другими значениями.# Замена пропущенных значений на -1 my_dataframe_replaced = my_dataframe.replace({pd.NA: -1, None: -1})

- Метод

Параметры функций dropna() и fillna()

dropna()

DataFrame.dropna(axis=0, how='any', thresh=None, subset=None, inplace=False)

- axis: Определяет ось, по которой будет производиться удаление пропущенных значений. По умолчанию

axis=0, что означает удаление строк с пропущенными значениями. Еслиaxis=1, то удаляются столбцы. - how: Определяет, какие строки или столбцы удалять. Возможные значения:

'any': Удаляет строки или столбцы, содержащие хотя бы одно пропущенное значение.'all': Удаляет строки или столбцы, содержащие только пропущенные значения.

- thresh: Определяет минимальное количество непропущенных значений, необходимых для сохранения строки или столбца.

- subset: Список столбцов или индексов, для которых нужно рассматривать пропущенные значения при принятии решения о удалении.

- inplace: Если

True, изменения будут применены к самому DataFrame и функция ничего не возвращает. ЕслиFalse(по умолчанию), функция возвращает новый DataFrame без пропущенных значений.

fillna()

DataFrame.fillna(value=None, method=None, axis=None, inplace=False, limit=None, downcast=None)

- value: Значение, которым нужно заполнить пропущенные ячейки.

- method: Метод, который можно использовать для заполнения пропущенных значений. Возможные значения:

'ffill'или'pad': Заполняет пропущенные значения предыдущими ненулевыми значениями.'bfill'или'backfill': Заполняет пропущенные значения следующими ненулевыми значениями.

- axis: Определяет ось, по которой будут заполняться пропущенные значения. По умолчанию (

axis=None) значения заполняются по столбцам. - inplace: Если

True, изменения будут применены к самому DataFrame и функция ничего не возвращает. ЕслиFalse(по умолчанию), функция возвращает новый DataFrame с заполненными значениями. - limit: Определяет максимальное количество последовательных пропущенных значений, которые будут заполнены.

- downcast: Указывает, можно ли понизить типы данных для оптимизации.

Вычисления в данных и применение функций к значениям датафрейма

В Pandas арифметические операции и функции могут быть применены к данным в DataFrame с помощью встроенных методов и функций библиотеки. Основные способы применения арифметических операций и функций к данным в DataFrame:

Арифметические операции:

- Сложение, вычитание, умножение и деление:

- Арифметические операции между DataFrame и другими структурами данных (другими DataFrame, Series, скалярными значениями) происходят поэлементно.

import pandas as pd # Создание DataFrame для примера data = {'A': [1, 2, 3], 'B': [4, 5, 6]} df = pd.DataFrame(data) # Сложение с скаляром result = df + 10 # Вычитание другого DataFrame other_data = {'A': [10, 20, 30], 'B': [40, 50, 60]} other_df = pd.DataFrame(other_data) result = df - other_df # Умножение на Series series = pd.Series([2, 2, 2], index=['A', 'B', 'C']) result = df * series # Деление на число result = df / 2

- Арифметические операции между DataFrame и другими структурами данных (другими DataFrame, Series, скалярными значениями) происходят поэлементно.

Применение функций:

- Применение функции к каждому элементу:

- Используйте метод

apply()для применения функции к каждому элементу в DataFrame.# Применение функции к каждому элементу result = df.apply(lambda x: x ** 2)

- Используйте метод

- Применение функции к столбцам или строкам:

- Используйте параметр

axisдля указания направления применения функции: 0 (по столбцам) или 1 (по строкам).# Применение функции к каждому столбцу result = df.apply(lambda x: x.max()) # Применение функции к каждой строке result = df.apply(lambda x: x.sum(), axis=1)

- Используйте параметр

- Применение встроенных функций:

- Pandas предоставляет множество встроенных функций для анализа данных, таких как

mean(),sum(),min(),max()и другие.# Вычисление среднего значения каждого столбца result = df.mean() # Вычисление суммы по строкам result = df.sum(axis=1)

- Pandas предоставляет множество встроенных функций для анализа данных, таких как

Пример работы с арифметическими операциями и функциями

Для примера работы с арифметическими операциями и применением функций на прикладных данных давайте возьмем данные о билетах из файла tickets.csv. Допустим, что мы хотим добавить новый столбец, который будет содержать количество символов в имени пассажира. Затем мы проведем арифметические операции с данными в этом столбце.

import pandas as pd

# Загрузка данных

tickets_df = pd.read_csv('tickets.csv')

# Функция для подсчета количества символов в имени пассажира

def count_characters(name):

return len(name)

# Применение функции к столбцу 'passenger_name' и создание нового столбца 'name_length'

tickets_df['name_length'] = tickets_df['passenger_name'].apply(count_characters)

# Вывод первых нескольких строк датафрейма с новым столбцом

print("Данные с новым столбцом:")

print(tickets_df.head())

# Пример арифметической операции: сумма длин идентификаторов билетов и идентификаторов пассажиров

total_length = tickets_df['ticket_no'].apply(len).sum() + tickets_df['passenger_id'].apply(len).sum()

print("\nОбщая длина всех идентификаторов билетов и пассажиров:", total_length)

Результаты:

Данные с новым столбцом:

ticket_no book_ref passenger_id passenger_name \

0 0005432000987 06B046 8149 604011 VALERIY TIKHONOV

1 0005432000988 06B046 8499 420203 EVGENIYA ALEKSEEVA

2 0005432000989 E170C3 1011 752484 ARTUR GERASIMOV

3 0005432000990 E170C3 4849 400049 ALINA VOLKOVA

4 0005432000991 F313DD 6615 976589 MAKSIM ZHUKOV

contact_data name_length

0 {"phone": "+70127117011"} 16

1 {"phone": "+70378089255"} 16

2 {"phone": "+70760429203"} 15

3 {"email": "volkova.alina_03101973@po... 11

4 {"email": "m-zhukov061972@postgrespr... 11

Общая длина всех идентификаторов билетов и пассажиров: 179

Как видно из результатов:

- Мы успешно добавили новый столбец «name_length», который содержит количество символов в имени пассажира.

- Проведена арифметическая операция, которая вычисляет сумму длин всех идентификаторов билетов и пассажиров.

Обработка пропущенных данных:

- Обнаружение пропущенных данных:

- Используйте методы

isna()илиisnull()для обнаружения пропущенных значений.# Обнаружение пропущенных значений missing_values = df.isna()

- Используйте методы

- Заполнение пропущенных данных:

- Используйте метод

fillna()для заполнения пропущенных значений определенным значением или методом.# Заполнение пропущенных значений нулями filled_df = df.fillna(0) # Заполнение пропущенных значений средним по столбцу filled_df = df.fillna(df.mean())

- Используйте метод

Пример работы с пропусками

Для демонстрации работы с пропущенными значениями давайте используем данные о рейсах из файла flights.csv. В этих данных возможно наличие пропущенных значений в столбцах «actual_departure» и «actual_arrival», которые указывают на фактическое время вылета и прибытия рейса.

Пример работы с пропущенными значениями будет заключаться в их обнаружении и обработке, например, заполнении пропущенных значений средним или медианным значением времени вылета и прибытия.

import pandas as pd

# Загрузка данных

flights_df = pd.read_csv('flights.csv')

# Вывод информации о пропущенных значениях

print("Информация о пропущенных значениях до обработки:")

print(flights_df.isnull().sum())

# Заполнение пропущенных значений средними значениями времени вылета и прибытия

flights_df['actual_departure'].fillna(flights_df['actual_departure'].mean(), inplace=True)

flights_df['actual_arrival'].fillna(flights_df['actual_arrival'].mean(), inplace=True)

# Вывод информации о пропущенных значениях после обработки

print("\nИнформация о пропущенных значениях после обработки:")

print(flights_df.isnull().sum())

Результаты:

Информация о пропущенных значениях до обработки:

flight_id 0

flight_no 0

scheduled_departure 0

scheduled_arrival 0

departure_airport 0

arrival_airport 0

status 0

aircraft_code 0

actual_departure 2017

actual_arrival 2356

dtype: int64

Информация о пропущенных значениях после обработки:

flight_id 0

flight_no 0

scheduled_departure 0

scheduled_arrival 0

departure_airport 0

arrival_airport 0

status 0

aircraft_code 0

actual_departure 0

actual_arrival 0

dtype: int64

В этом примере мы сначала выявили количество пропущенных значений в каждом столбце с помощью метода isnull().sum(). Затем мы заполнили пропущенные значения средними значениями времени вылета и прибытия с помощью метода fillna() с указанием среднего значения каждого столбца. После обработки пропущенных значений, выводим информацию о пропущенных значениях, чтобы убедиться, что они успешно заполнены.

Конвертация типов данных

Чтобы поменять тип данных у существующего столбца в DataFrame в Pandas, вы можете использовать метод astype() или функцию pd.to_numeric(), pd.to_datetime() или pd.to_timedelta(), в зависимости от типа данных, который вы хотите преобразовать.

Вот примеры использования этих методов:

- Метод

astype():import pandas as pd # Создание DataFrame для примера data = {'A': ['1', '2', '3', '4', '5'], 'B': [1, 2, 3, 4, 5]} df = pd.DataFrame(data) # Преобразование столбца 'A' к числовому типу данных df['A'] = df['A'].astype(int) print(df.dtypes) # Проверка типов данных после преобразования

- Функция

pd.to_numeric():import pandas as pd # Создание DataFrame для примера data = {'A': ['1', '2', '3', '4', '5'], 'B': [1, 2, 3, 4, 5]} df = pd.DataFrame(data) # Преобразование столбца 'A' к числовому типу данных df['A'] = pd.to_numeric(df['A']) print(df.dtypes) # Проверка типов данных после преобразования

- Функция

pd.to_datetime()(пример для преобразования столбца с датами):import pandas as pd # Создание DataFrame для примера data = {'Date': ['2022-01-01', '2022-01-02', '2022-01-03', '2022-01-04', '2022-01-05'], 'Value': [1, 2, 3, 4, 5]} df = pd.DataFrame(data) # Преобразование столбца 'Date' к типу данных datetime df['Date'] = pd.to_datetime(df['Date']) print(df.dtypes) # Проверка типов данных после преобразования

- Функция

pd.to_timedelta()(пример для преобразования столбца с временными интервалами):import pandas as pd # Создание DataFrame для примера data = {'Date': ['2022-01-01', '2022-01-02', '2022-01-03', '2022-01-04', '2022-01-05'], 'Value': [1, 2, 3, 4, 5]} df = pd.DataFrame(data) # Преобразование столбца 'Date' к типу данных datetime df['Date'] = pd.to_datetime(df['Date']) print(df.dtypes) # Проверка типов данных после преобразования

После выполнения преобразований вы можете проверить типы данных с помощью метода dtypes.

Пример работы с конвертацией данных

Для демонстрации конвертации типов данных и использования категориальных данных давайте возьмем данные о билетах из файла tickets.csv. Допустим, что столбец «fare_conditions» (условия тарифа) может быть конвертирован в категориальный тип данных.

import pandas as pd

# Загрузка данных

tickets_df = pd.read_csv('tickets.csv')

# Вывод информации о типах данных до конвертации

print("Типы данных до конвертации:")

print(tickets_df.dtypes)

# Конвертация типа данных столбца "fare_conditions" в категориальный тип

tickets_df['fare_conditions'] = tickets_df['fare_conditions'].astype('category')

# Вывод информации о типах данных после конвертации

print("\nТипы данных после конвертации:")

print(tickets_df.dtypes)

Результаты:

Типы данных до конвертации:

ticket_no object

book_ref object

passenger_id object

passenger_name object

contact_data object

fare_conditions object

dtype: object

Типы данных после конвертации:

ticket_no object

book_ref object

passenger_id object

passenger_name object

contact_data object

fare_conditions category

dtype: object

Как видно из результатов, столбец «fare_conditions» был успешно конвертирован в категориальный тип данных после использования метода astype('category'). Это позволит оптимизировать использование памяти и улучшить производительность операций с этим столбцом, особенно при работе с большими объемами данных.

Работа с мультииндексом

Мультииндекс (MultiIndex) в Pandas — это инструмент для работы с данными, где индексом может быть несколько уровней, что позволяет организовать иерархическую структуру данных. Мультииндексы особенно полезны для представления многомерных или многотерминальных данных.

Создание мультииндекса:

- Создание мультииндекса при создании DataFrame:

import pandas as pd # Создание DataFrame с мультииндексом data = { ('Группа 1', 'Понедельник'): [10, 20, 30], ('Группа 1', 'Вторник'): [40, 50, 60], ('Группа 2', 'Понедельник'): [70, 80, 90], ('Группа 2', 'Вторник'): [100, 110, 120] } df = pd.DataFrame(data, index=['Иван', 'Мария', 'Алексей']) - Создание мультииндекса из существующего DataFrame:

# Создание мультииндекса из существующего столбца df.set_index(['Группа 1', 'Группа 2'], inplace=True)

Работа с мультииндексами:

- Индексация по мультииндексу:

# Выбор данных по индексу верхнего уровня group1_data = df.loc['Группа 1'] # Выбор данных по индексу нижнего уровня monday_data = df.loc[:, 'Понедельник'] - Переименование индексов:

# Переименование индексов df.index.names = ['Группа', 'День'] - Обращение к данным по мультииндексу:

# Доступ к конкретному значению по индексу value = df.loc[('Группа 1', 'Понедельник'), 'Иван'] - Группировка и агрегирование по мультииндексу:

# Группировка данных по верхнему уровню индекса group1_mean = df.groupby(level='Группа').mean()

Результат работы:

print(df)

Группа Группа 1 Группа 2

День Понедельник Вторник Понедельник Вторник

Иван 10 40 70 100

Мария 20 50 80 110

Алексей 30 60 90 120

В результате выполнения указанных операций мы создали DataFrame с мультииндексом, а также продемонстрировали различные способы работы с данными, включая индексацию, обращение, переименование индексов, группировку и агрегирование данных.

Добавление новых строк:

- Использование метода

append():- Метод

append()позволяет добавить новую строку в DataFrame. Обратите внимание, что он возвращает новый объект DataFrame, поэтому исходный объект остается неизменным.import pandas as pd # Создание DataFrame для примера data = {'Имя': ['Анна', 'Борис'], 'Возраст': [25, 30]} df = pd.DataFrame(data) # Добавление новой строки с помощью append() new_row = pd.Series(['Светлана', 22], index=df.columns) df = df.append(new_row, ignore_index=True)

- Метод

- Использование списков или словарей:

- Можно создать новую строку в виде списка или словаря и добавить ее как новый элемент в DataFrame.

# Создание новой строки в виде списка и добавление ее в DataFrame new_row = ['Светлана', 22] df.loc[len(df)] = new_row # Создание новой строки в виде словаря и добавление ее в DataFrame new_row = {'Имя': 'Светлана', 'Возраст': 22} df = df.append(new_row, ignore_index=True)

- Можно создать новую строку в виде списка или словаря и добавить ее как новый элемент в DataFrame.

Добавление новых столбцов:

- Простое присваивание:

- Новый столбец может быть добавлен простым присваиванием значения или Series.

# Присваивание значения новому столбцу df['Зарплата'] = [50000, 60000, 45000] # Присваивание Series новому столбцу new_column = pd.Series([50000, 60000, 45000], name='Зарплата') df['Зарплата'] = new_column

- Новый столбец может быть добавлен простым присваиванием значения или Series.

- Использование метода

insert():- Метод

insert()позволяет добавить новый столбец на определенную позицию в DataFrame.# Добавление нового столбца на определенную позицию df.insert(loc=1, column='Зарплата', value=[50000, 60000, 45000])

- Метод

Полная программа:

import pandas as pd

# Создание DataFrame для примера

data = {'Имя': ['Анна', 'Борис'],

'Возраст': [25, 30]}

df = pd.DataFrame(data)

# Добавление новой строки с помощью append()

new_row = pd.Series(['Светлана', 22], index=df.columns)

df = df.append(new_row, ignore_index=True)

# Создание новой строки в виде списка и добавление ее в DataFrame

new_row = ['Светлана', 22]

df.loc[len(df)] = new_row

# Создание новой строки в виде словаря и добавление ее в DataFrame

new_row = {'Имя': 'Светлана', 'Возраст': 22}

df = df.append(new_row, ignore_index=True)

# Присваивание значения новому столбцу

df['Зарплата'] = [50000, 60000, 45000]

# Присваивание Series новому столбцу

new_column = pd.Series([50000, 60000, 45000], name='Зарплата')

df['Зарплата'] = new_column

# Добавление нового столбца на определенную позицию

df.insert(loc=1, column='Зарплата', value=[50000, 60000, 45000])

print(df)

Вывод

Имя Зарплата Возраст

0 Анна 50000 25

1 Борис 60000 30

2 Светлана 45000 22

Удаление строк и столбцов

Чтобы удалить строки или столбцы по их индексам или именам (значениям), можно использовать методы drop() для удаления строк и drop(columns=[]) для удаления столбцов. Давайте рассмотрим примеры.

Удаление строк по индексам

import pandas as pd

# Создание DataFrame для примера

data = {'A': [1, 2, 3], 'B': [4, 5, 6]}

df = pd.DataFrame(data)

# Удаление строк по индексам

df.drop([0, 2], inplace=True)

print(df)

Этот код удалит строки с индексами 0 и 2 из DataFrame.

Удаление строк по значениям в столбце

import pandas as pd

# Создание DataFrame для примера

data = {'A': [1, 2, 3], 'B': [4, 5, 6]}

df = pd.DataFrame(data)

# Удаление строк по значениям в столбце

df = df[df['A'] != 2]

print(df)

Этот код удалит строки с индексами 0 и 2 из DataFrame.

Удаление строк по значениям в столбце

import pandas as pd

# Создание DataFrame для примера

data = {'A': [1, 2, 3], 'B': [4, 5, 6]}

df = pd.DataFrame(data)

# Удаление строк по значениям в столбце

df = df[df['A'] != 2]

print(df)

Этот код удалит строки, в которых значение в столбце ‘A’ равно 2.

Удаление столбцов по именам

import pandas as pd

# Создание DataFrame для примера

data = {'A': [1, 2, 3], 'B': [4, 5, 6], 'C': [7, 8, 9]}

df = pd.DataFrame(data)

# Удаление столбцов по именам

df.drop(columns=['B'], inplace=True)

print(df)

Этот код удалит столбец ‘B’ из DataFrame.

Удаление столбцов по индексам

import pandas as pd

# Создание DataFrame для примера

data = {'A': [1, 2, 3], 'B': [4, 5, 6], 'C': [7, 8, 9]}

df = pd.DataFrame(data)

# Удаление столбцов по индексам

df.drop(df.columns[[1]], axis=1, inplace=True)

print(df)

Этот код удалит столбец с индексом 1 из DataFrame.

Обратите внимание, что параметр inplace=True используется для изменения исходного DataFrame. Если inplace=False (по умолчанию), метод drop() вернет новый DataFrame без удаленных строк или столбцов, не изменяя исходный DataFrame.

Переименование столбцов

Чтобы переименовать столбец в Pandas DataFrame, можно использовать метод rename() с параметром columns.

Переименование одного столбца

import pandas as pd

# Создание DataFrame для примера

data = {'old_name': [1, 2, 3], 'B': [4, 5, 6]}

df = pd.DataFrame(data)

# Переименование столбца 'old_name' на 'new_name'

df.rename(columns={'old_name': 'new_name'}, inplace=True)

print(df)

Переименование нескольких столбцов

import pandas as pd

# Создание DataFrame для примера

data = {'old_name_1': [1, 2, 3], 'old_name_2': [4, 5, 6]}

df = pd.DataFrame(data)

# Переименование столбцов 'old_name_1' и 'old_name_2' на 'new_name_1' и 'new_name_2'

df.rename(columns={'old_name_1': 'new_name_1', 'old_name_2': 'new_name_2'}, inplace=True)

print(df)

Обратите внимание, что параметр inplace=True используется для изменения исходного DataFrame. Если inplace=False (по умолчанию), метод rename() вернет новый DataFrame с переименованными столбцами, не изменяя исходный DataFrame.

Вычисляемые столбцы

Чтобы добавить новый столбец в DataFrame в Pandas, вы можете просто присвоить новый столбец и присвоить ему значения, вычисленные на основе значений других столбцов или с использованием функций. Вот несколько примеров:

Пример 1: Добавление столбца с вычисленными значениями:

import pandas as pd

# Создание DataFrame для примера

data = {'A': [1, 2, 3],

'B': [4, 5, 6]}

df = pd.DataFrame(data)

# Добавление нового столбца "C" с вычисленными значениями

df['C'] = df['A'] + df['B']

print(df)

Вывод:

A B C

0 1 4 5

1 2 5 7

2 3 6 9

Пример 2: Добавление столбца с применением функции:

import pandas as pd

# Создание DataFrame для примера

data = {'A': [1, 2, 3],

'B': [4, 5, 6]}

df = pd.DataFrame(data)

# Функция, которая будет применена к столбцам для вычисления нового значения

def custom_function(row):

return row['A'] * 2 + row['B'] * 3

# Добавление нового столбца "C" с применением функции

df['C'] = df.apply(custom_function, axis=1)

print(df)

Вывод:

A B C

0 1 4 14

1 2 5 19

2 3 6 24

Создание вычисляемого столбца с помощью assign()

df.assign:

- Назначение: Создает новые столбцы в DataFrame на основе существующих данных.

- Параметры: Принимает именованные аргументы, где ключи — это названия новых столбцов, а значения — это выражения, определяющие их значения.

- Пример использования:

import pandas as pd # Создаем DataFrame df = pd.DataFrame({'A': [1, 2, 3, 4], 'B': [5, 6, 7, 8]}) # Используем метод assign для создания нового столбца df = df.assign(C=lambda x: x['A'] + x['B']) print(df) - Результат работы

A B C 0 1 5 6 1 2 6 8 2 3 7 10 3 4 8 12

Преобразование столбцов в строки. Метод melt()

Метод melt в библиотеке Pandas используется для преобразования «широкого» формата данных в «длинный» формат. Этот процесс иногда называют «расплавлением» данных. То есть, имеется много «типовых» столбцов.

Например: у нас есть данные по продажам. Отдельные столбцы — месяцы продаж, в строках — сумма продаж за конкретный месяц. Мы можем, оставить два столбца — сумма продаж и название месяца. Таким образом, данные из столбцов уйдут в строки. Это сделает анализ данных гораздо удобнее. Например, проще будет найти среднюю сумму продаж.

Основная цель melt — сделать данные более удобными для анализа и визуализации, особенно при работе с временными рядами, многомерными данными и данными, собранными в широком формате.

Например, если у нас есть датафрейм, где переменные представлены в столбцах, и каждая строка представляет наблюдение, можно использовать melt, чтобы преобразовать этот формат данных в формат, где переменные будут представлены в столбце «variable», а соответствующие значения — в столбце «value».

Основные параметры метода melt:

- id_vars: Список или кортеж названий столбцов, которые нужно оставить в исходном виде (например, идентификаторы или категории).

- value_vars: Список или кортеж названий столбцов, которые нужно преобразовать в значения в новом столбце.

- var_name: Название нового столбца, в который будут записаны имена переменных из старых столбцов (по умолчанию «variable»).

- value_name: Название нового столбца, в который будут записаны значения переменных (по умолчанию «value»).

Пример использования melt:

Допустим, у нас есть следующий датафрейм с данными о продажах товаров в различных магазинах за разные месяцы:

import pandas as pd

data = {

'Месяц': ['Январь', 'Февраль', 'Март'],

'Магазин A': [1000, 1500, 1200],

'Магазин B': [900, 1400, 1100],

'Магазин C': [1100, 1600, 1300]

}

df = pd.DataFrame(data)

print(df)

Этот датафрейм имеет широкий формат, где каждый месяц представлен в отдельном столбце. Мы можем преобразовать его в длинный формат, используя melt:

melted_df = df.melt(id_vars=['Месяц'], var_name='Магазин', value_name='Продажи')

print(melted_df)

Результат:

Месяц Магазин Продажи

0 Январь Магазин A 1000

1 Февраль Магазин A 1500

2 Март Магазин A 1200

3 Январь Магазин B 900

4 Февраль Магазин B 1400

5 Март Магазин B 1100

6 Январь Магазин C 1100

7 Февраль Магазин C 1600

8 Март Магазин C 1300

Теперь каждая строка содержит информацию о продажах в конкретном месяце и магазине, что делает данные более удобными для анализа.

Задания на закрепление

Для выполнения заданий, скачайте и распакуйте источник данных в папку с вашим Python файлом.

Задание 1. Получите информацию о типах данных в датафрейме.

Задание 2. Выведите первые 5 строк датафрейма.

Задание 3. Выведите список уникальных стран, представленных в датафрейме.

Задание 4. Отфильтруйте строки, где количество подписчиков больше 70 миллионов.

Задание 5. Создайте новый столбец «Total Followers», который будет представлять сумму подписчиков и дополнительных подписчиков бренда (если указано).

Задание 6. Выведите количество аккаунтов из каждой страны.

Задание 7. Переименуйте столбец «Followers (millions)» в «Followers» и удалите лишние символы из значений этого столбца.

Задание 8. Сортируйте датафрейм по убыванию количества подписчиков.

Задание 9. Создайте новый датафрейм, который будет содержать только пользователей из США.

Задание 10. Создайте сводную таблицу, показывающую среднее количество подписчиков для каждой страны.

import pandas as pd

# Загрузка данных

df = pd.read_csv("List of most-followed TikTok accounts (1).csv")

# Задание 1. Получите информацию о типах данных в датафрейме.

print("Задание 1:")

print(df.dtypes)

print()

# Задание 2. Выведите первые 5 строк датафрейма.

print("Задание 2:")

print(df.head())

print()

# Задание 3. Выведите список уникальных стран, представленных в датафрейме.

print("Задание 3:")

print(df['Country'].unique())

print()

# Задание 4. Отфильтруйте строки, где количество подписчиков больше 70 миллионов.

print("Задание 4:")

print(df[df['Followers (millions)'] > 70])

print()

# Задание 5. Создайте новый столбец "Total Followers", который будет представлять сумму подписчиков и дополнительных подписчиков бренда (если указано).

print("Задание 5:")

df['Total Followers'] = df['Followers (millions)'] + df['Brand\nAccount'].fillna(0)

print(df)

print()

# Задание 6. Выведите количество аккаунтов из каждой страны.

print("Задание 6:")

print(df['Country'].value_counts())

print()

# Задание 7. Переименуйте столбец "Followers (millions)" в "Followers" и удалите лишние символы из значений этого столбца.

print("Задание 7:")

df.rename(columns={'Followers (millions)': 'Followers'}, inplace=True)

df['Followers'] = df['Followers'].str.replace(',', '').astype(float)

print(df)

print()

# Задание 8. Сортируйте датафрейм по убыванию количества подписчиков.

print("Задание 8:")

df_sorted = df.sort_values(by='Followers', ascending=False)

print(df_sorted)

print()

# Задание 9. Создайте новый датафрейм, который будет содержать только пользователей из США.

print("Задание 9:")

df_usa = df[df['Country'] == 'United States']

print(df_usa)

print()

# Задание 10. Создайте сводную таблицу, показывающую среднее количество подписчиков для каждой страны.

print("Задание 10:")

pivot_table = df.pivot_table(values='Followers', index='Country', aggfunc='mean')

print(pivot_table)

Сортировка, группировка и агрегация данных в Pandas

Сортировка данных

Простая сортировка по одному полю:

import pandas as pd

# Создание DataFrame для примера

data = {'Name': ['John', 'Alice', 'Bob'],

'Age': [25, 30, 22],

'Salary': [50000, 60000, 45000]}

df = pd.DataFrame(data)

# Простая сортировка по возрасту (по умолчанию - в порядке возрастания)

sorted_df = df.sort_values(by='Age')

print(sorted_df)

Сложная сортировка по нескольким полям:

# Сложная сортировка: сначала по возрасту, затем по зарплате (по умолчанию - в порядке возрастания)

sorted_df = df.sort_values(by=['Age', 'Salary'])

print(sorted_df)

Сортировка, использующая выражения в качестве критерия сравнения:

# Сортировка по длине имени в алфавитном порядке

sorted_df = df.iloc[df['Name'].str.len().sort_values().index]

print(sorted_df)

В этих примерах sort_values() используется для сортировки данных. Метод принимает аргумент by, который может быть именем столбца или списком имен столбцов для сортировки. По умолчанию сортировка происходит в порядке возрастания, но это можно изменить, установив параметр ascending=False. Кроме того, для более сложной сортировки вы можете использовать выражения в качестве критерия сравнения.

Получение наибольших и наименьших значений к столбцу (series)

Методы nsmallest и nlargest в библиотеке Pandas используются для нахождения наименьших или наибольших значений в заданной серии или столбце данных. Эти методы предпочтительны, когда необходимо найти ограниченное количество значений среди большого набора данных, так как они выполняют поиск среди первых n наименьших или наибольших значений, не требуя сортировки всего набора данных.

Обзор основных параметров методов nsmallest и nlargest:

- n: Количество наименьших или наибольших значений, которые нужно найти.

- keep: Указывает, должны ли быть сохранены все значения с одинаковым рангом. Параметр может принимать значения ‘first’, ‘last’ или False. Если ‘first’, сохраняется первое встреченное значение с указанным рангом, если ‘last’ — последнее, если False — все значения удаляются.

Примеры использования методов nsmallest и nlargest:

- Пример использования метода

nsmallest:import pandas as pd # Создание датафрейма с данными data = {'Name': ['John', 'Alice', 'Bob', 'Emily', 'David'], 'Score': [85, 90, 75, 80, 95]} df = pd.DataFrame(data) # Нахождение двух наименьших значений в столбце 'Score' smallest_scores = df['Score'].nsmallest(2) print("Две наименьшие оценки:") print(smallest_scores)Результат:

Две наименьшие оценки: 2 75 3 80 Name: Score, dtype: int64 - Пример использования метода

nlargest:import pandas as pd # Создание датафрейма с данными data = {'Name': ['John', 'Alice', 'Bob', 'Emily', 'David'], 'Score': [85, 90, 75, 80, 95]} df = pd.DataFrame(data) # Нахождение трех наибольших значений в столбце 'Score' largest_scores = df['Score'].nlargest(3) print("Три наибольшие оценки:") print(largest_scores)Результат:

Три наибольшие оценки: 4 95 1 90 0 85 Name: Score, dtype: int64

Таким образом, методы nsmallest и nlargest удобны для быстрого нахождения наименьших или наибольших значений в столбце данных без необходимости полной сортировки всего набора данных.

Получение уникальных значений

Для получения уникальных значений одного или нескольких столбцов в Pandas вы можете использовать метод unique().

Получение уникальных значений одного столбца:

import pandas as pd

# Создание DataFrame для примера

data = {'Name': ['John', 'Alice', 'Bob', 'Alice', 'John'],

'Age': [25, 30, 22, 30, 25]}

df = pd.DataFrame(data)

# Получение уникальных значений столбца "Name"

unique_names = df['Name'].unique()

print(unique_names)

Этот код выведет:

['John' 'Alice' 'Bob']

Получение уникальных значений нескольких столбцов:

# Получение уникальных значений столбцов "Name" и "Age"

unique_values = df[['Name', 'Age']].drop_duplicates()

print(unique_values)

Этот код выведет:

Name Age

0 John 25

1 Alice 30

2 Bob 22

Метод unique() возвращает массив уникальных значений для указанного столбца. Если вам нужно получить уникальные значения из нескольких столбцов, вы можете использовать метод drop_duplicates() после выбора этих столбцов.

import pandas as pd

# Создание DataFrame для примера

data = {'Name': ['John', 'Alice', 'Bob', 'Alice', 'John'],

'Age': [25, 30, 22, 30, 25]}

df = pd.DataFrame(data)

# Получение уникальных значений столбцов "Name" и "Age"

unique_values = df[['Name', 'Age']].drop_duplicates()

print("Уникальные значения столбцов 'Name' и 'Age':")

print(unique_values)

Этот код выведет:

Name Age

0 John 25

1 Alice 30

2 Bob 22

Метод drop_duplicates() удаляет повторяющиеся строки в DataFrame, сохраняя только первое вхождение каждой уникальной строки. В данном случае он сохраняет только уникальные комбинации значений столбцов «Name» и «Age».

Количество уникальных значений

- Метод

nunique()возвращает количество уникальных значений в столбце данных. - Этот метод возвращает число, представляющее количество уникальных значений в столбце.

- Это полезно для быстрой проверки количества уникальных значений в столбце без необходимости создавать массив уникальных значений.

import pandas as pd

data = {'A': [1, 2, 3, 1, 2, 3]}

df = pd.DataFrame(data)

num_unique_values = df['A'].nunique()

print(num_unique_values)

# Output: 3

Агрегатные функции

Агрегатные функции в Pandas позволяют вычислять статистические метрики для данных в DataFrame.

- len(): Этf функция возвращает количество элементов в объекте. Если применяется к DataFrame, он возвращает количество строк.

value_counts(): Этот метод используется для подсчета уникальных значений в столбце или серии данных. Возвращает серию, в которой индексы — уникальные значения, а значения — количество их появлений.Параметры:normalize: если установлен в True, возвращает относительные частоты вместо абсолютных.ascending: если установлен в True, сортирует результаты по возрастанию.

Пример использования:

import pandas as pd # Создание DataFrame data = {'Город': ['Москва', 'Санкт-Петербург', 'Москва', 'Санкт-Петербург', 'Казань']} df = pd.DataFrame(data) # Подсчет количества уникальных значений в столбце "Город" counts = df['Город'].value_counts() print(counts)nunique(): Этот метод возвращает количество уникальных значений в столбце или серии данных.Пример использования:import pandas as pd # Создание DataFrame data = {'Город': ['Москва', 'Санкт-Петербург', 'Москва', 'Санкт-Петербург', 'Казань']} df = pd.DataFrame(data) # Вывод количества уникальных значений в столбце "Город" print(df['Город'].nunique())- sum(): Вычисляет сумму значений в столбце или строке.

- mean(): Вычисляет среднее значение.

- median(): Вычисляет медиану (серединное значение в упорядоченном ряду).

- min(): Находит минимальное значение.

- max(): Находит максимальное значение.

- count(): Подсчитывает количество непустых значений.

- std(): Вычисляет стандартное отклонение (меру разброса данных относительно среднего значения).

- var(): Вычисляет дисперсию (средний квадрат отклонения от среднего).

- agg(): Выполняет пользовательскую агрегацию, применяя одну или несколько агрегатных функций к столбцам или строкам в DataFrame.

- describe(): Предоставляет сводную статистическую информацию о числовых столбцах в DataFrame (среднее, стандартное отклонение, минимум, 25-й, 50-й, и 75-й перцентили, максимум).

- quantile(): Вычисляет квантили (значения, разделяющие упорядоченный набор данных на равные части).

Простая агрегация:

import pandas as pd

# Создание DataFrame для примера

data = {'Name': ['John', 'Alice', 'Bob'],

'Age': [25, 30, 22],

'Salary': [50000, 60000, 45000]}

df = pd.DataFrame(data)

# Вычисление среднего значения зарплаты

mean_salary = df['Salary'].mean()

print("Средняя зарплата:", mean_salary)

# Вычисление суммы возрастов

total_age = df['Age'].sum()

print("Сумма возрастов:", total_age)

# Получение максимального возраста

max_age = df['Age'].max()

print("Максимальный возраст:", max_age)

Множественная агрегация:

# Множественная агрегация: вычисление среднего, суммы и максимального значения для нескольких столбцов

aggregated_data = df.agg({'Age': ['mean', 'sum', 'max'], 'Salary': ['mean', 'sum', 'max']})

print(aggregated_data)

Агрегация с условием:

# Агрегация с условием: вычисление среднего возраста для записей, где зарплата больше 50000

average_age_high_salary = df[df['Salary'] > 50000]['Age'].mean()

print("Средний возраст для зарплаты больше 50000:", average_age_high_salary)

Группировка данных

Группировка данных — это одна из важных операций в анализе данных, позволяющая разделить данные на группы по определенным критериям и применить к каждой группе агрегатные функции или другие операции. В Pandas для этого используется метод groupby().

Разбиение данных на группы:

Для разбиения данных на группы вы указываете столбец(ы), по которым нужно произвести группировку.

import pandas as pd

# Создание DataFrame для примера

data = {'Name': ['John', 'Alice', 'Bob', 'Alice', 'John'],

'Age': [25, 30, 22, 30, 25],

'Salary': [50000, 60000, 45000, 55000, 52000]}

df = pd.DataFrame(data)

# Группировка данных по столбцу "Name"

grouped = df.groupby('Name')

Применение функций к группам:

После группировки вы можете применить агрегатные функции или пользовательские функции к каждой группе.

# Примеры применения агрегатных функций

print(grouped.mean()) # Вычисление средних значений для каждой группы

print(grouped.max()) # Нахождение максимальных значений для каждой группы

print(grouped['Age'].min()) # Нахождение минимального возраста для каждой группы

# Пример применения пользовательской функции

def age_range(group):

return group['Age'].max() - group['Age'].min()

print(grouped.apply(age_range)) # Вычисление диапазона возрастов для каждой группы

Работа с множественными ключами группировки:

Также можно проводить группировку по нескольким столбцам, передав список столбцов в groupby().

# Группировка данных по столбцам "Name" и "Age"

grouped = df.groupby(['Name', 'Age'])

# Примеры применения агрегатных функций

print(grouped.mean()) # Вычисление средних значений для каждой группы

print(grouped.max()) # Нахождение максимальных значений для каждой группы

Применение нескольких функций к группам:

Можно также применять несколько агрегатных функций к группам с помощью метода agg().

# Пример применения нескольких функций к группам

result = grouped['Salary'].agg(['mean', 'sum', 'max'])

print(result)

Функции agg и size

Функция группировки agg (от «aggregate») в библиотеке Pandas позволяет применять одну или несколько агрегирующих функций к данным внутри групп. Она обычно используется вместе с методом groupby для выполнения агрегации на группах данных.

Основные моменты использования agg:

- Применение одной агрегирующей функции к нескольким столбцам:

df.groupby('группировочный столбец').agg({'столбец1': 'агрегирующая_функция1', 'столбец2': 'агрегирующая_функция2'}) - Применение нескольких агрегирующих функций к одному столбцу:

df.groupby('группировочный столбец')['столбец'].agg(['агрегирующая_функция1', 'агрегирующая_функция2']) - Применение различных агрегирующих функций к разным столбцам:

df.groupby('группировочный столбец').agg({'столбец1': 'агрегирующая_функция1', 'столбец2': 'агрегирующая_функция2'}) - Применение пользовательских функций:

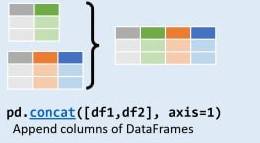

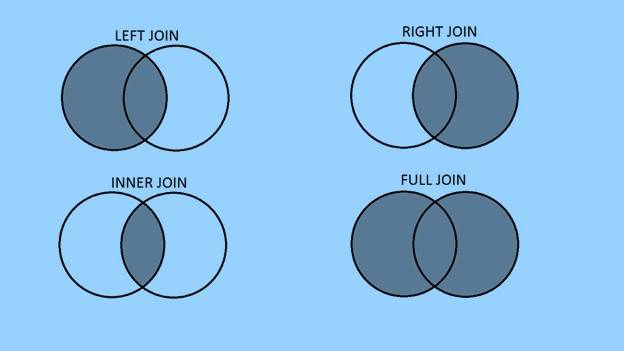

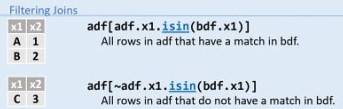

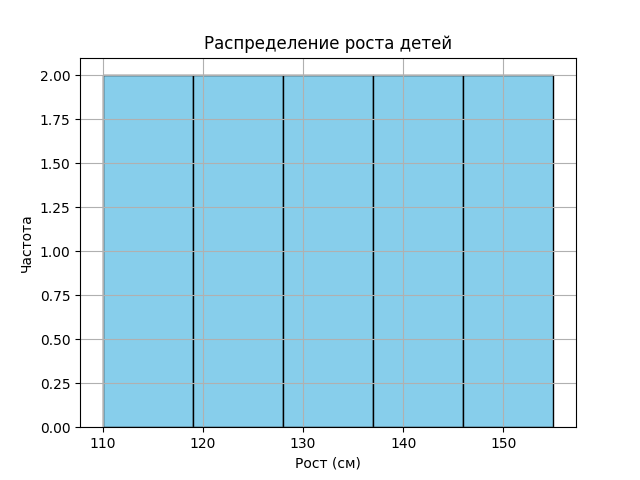

def custom_function(x): # логика вашей пользовательской функции return результат df.groupby('группировочный столбец').agg({'столбец': custom_function})